Vielfalt der Stimmen - epd medien

14.02.2026 08:06

Was ein Medienstaatsvertrag für KI regeln sollte

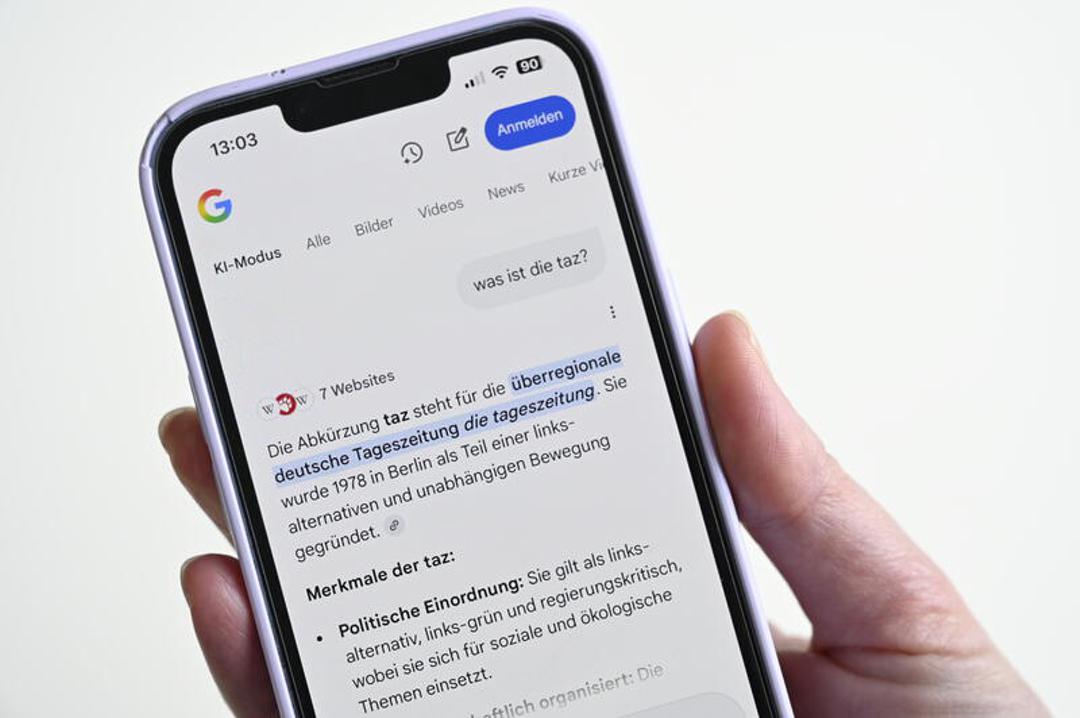

epd Die Nutzung von Künstlicher Intelligenz (KI) wird immer alltäglicher. Nach einer Untersuchung des Centrums für Hochschulforschung nutzte Anfang 2025 ein Viertel der Studierenden täglich Sprachmodelle wie Chat GPT, weitere 40 Prozent nutzten sie mindestens einmal wöchentlich. KI bestimmt zunehmend unser Verhältnis zur Wirklichkeit.

Kein Wunder, dass der Hamburger Senator für Kultur und Medien Carsten Brosda kürzlich Alarm schlug: "Die massenhafte und weitgehend unregulierte Verbreitung von Medieninhalten, die mithilfe oder gar gänzlich von Künstlicher Intelligenz generiert wurden, bedroht wesentliche Grundlagen unserer kommunikativen Öffentlichkeit", schrieb er in der "Frankfurter Allgemeinen Zeitung". Schon heute sei für den Laien kaum noch zu überprüfen, "welcher Inhalt Vertrauen verdient und welcher nicht". Er warnte: "Alle klassischen Marker für Glaubwürdigkeit und Relevanz verschwinden. An ihre Stelle tritt eine nochmals rapide anschwellende Informations- und Datenflut, die den Raum der gemeinsamen Verständigung zu überschwemmen droht."

Die Stimme des Volkes

Fragte man ChatGPT im Oktober 2025, wie ein Sprachmodell zu seinen Inhalten kommt, erhielt man diese Antwort: "Es wird mit riesigen Mengen an Texten aus dem Internet trainiert - Bücher, Zeitungsartikel, Webseiten, wissenschaftliche Arbeiten, Forenbeiträge usw." Man erfährt zugleich, dass das Modell diese Inhalte nicht etwa lernt und bei einer Frage entsprechend rezitiert. Vielmehr errechnet es statistische Verhältnisse unter den Wörtern und Wortkombinationen, also beispielsweise, wie oft die Zahl "1989" mit dem Begriff "Mauerfall" verbunden ist oder "Gleichberechtigung" beziehungsweise "Unsittlichkeit" mit "Homosexualität".

Ein Sprachmodell, so das Fazit von ChatGPT-5, "hat keine Inhalte im klassischen Sinn, sondern statistisch kondensierte Spuren menschlicher Sprache. Es reproduziert und rekombiniert, was Menschen gesagt, gedacht und geschrieben haben - ohne zu wissen, was das bedeutet."

Eine aggregierte, globale Sprechweise

Was ein Sprachmodell über die Welt sagt, hängt also maßgeblich davon ab, wie die Texte, die ihm vorliegen, diese beschreiben. Wenn die Statistik ergibt, dass der Begriff "Schwangerschaftsabbruch" wesentlich öfter mit der Formulierung "pro Choice" verbunden ist als mit der Formulierung "pro Life", wird sich das Sprachmodell eher positiv über Schwangerschaftsabbruch äußern - wobei es Negationen wie "ich bin gegen pro Choice" natürlich in Rechnung stellt.

Da liegt die Anschlussfrage nahe, ob das Sprachmodell also die "Stimme des Volkes" ist. Antwort von ChatGPT-5: Da ein Sprachmodell "aus Abermillionen von Äußerungen realer Menschen" gespeist werde, sei es "tatsächlich eine 'Stimme des Volkes' - aber nicht die eines bestimmten Volkes, sondern eine aggregierte, globale Sprechweise." Dann ist das Sprachmodell das Sprachrohr aller Völker? Ist die Sprachmaschine also eine kosmopolitische Maschine?

Moralisch regulierte Stimme

Aber halt, da steht noch etwas: "Die 'Volksstimme' wird im Trainingsprozess technisch und normativ gefiltert." In diesem Prozess, so ChatGPT-5, werden toxische, diskriminierende, pornografische oder politisch heikle Inhalte entfernt und bestimmte Werte wie Respekt und Inklusion vermittelt. Dadurch spreche das Modell "nicht mehr für das Volk, sondern für eine bestimmte Vorstellung davon, wie das Volk sprechen sollte - eine moralisch und politisch regulierte Stimme."

Also halb Stimme der Völker, halb Stimme einer moralischen Instanz, die im Finetuning das korrigiert, was das Sprachmodell vom Volk - beziehungsweise den Völkern dieser Welt - gelernt hat? Wer ist diese moralische Instanz? Woher kommen ihre Mitarbeiter und was qualifiziert sie für diese Aufgabe?

Die Dominanz des Progressiven

So viel ist bekannt: Beim ChatGPT-Unternehmen OpenAI ist diese Instanz ein kleines "Model-Behavior-Team", das sich zwar mit einigen Moralphilosophen und Technik-Ethikern berät, am Ende aber recht selbstständig entscheidet, wie das Wertesystem des Sprachmodells aussehen und damit die Stimme der Völker sich anhören soll.

Sam Altman, der CEO von OpenAI, kann, wenn er will, diese Entscheidungen am Ende überstimmen. Das sagte Altmann selbst im Podcast des rechts-konservativen Tucker Carlson, der genauer wissen wollte, wer eigentlich den Sprachmodellen die Moral beibringt. Dass Tucker da misstrauischer ist als links-liberale Beobachter, liegt sicher auch daran, dass sich ChatGPT früh recht "woke" verhielt. Zumindest wurde von Rechten recht früh dieser Vorwurf erhoben, denn ChatGPT nahm die LGBTQ-Community in Schutz und verhielt sich auch sonst in jeder Hinsicht und manchmal in absurdem Ausmaß politisch korrekt.

Moralische Ausrichtung

Wie Studien in den USA, Deutschland und den Niederlanden aus den Jahren 2023 und 2024 gezeigt haben, rücken Sprachmodelle während ihrer "Zweiterziehung" per Finetuning nach links: Sie befürworten Klimasteuern, Mietenkontrolle, Abtreibungsrecht, eine höhere Besteuerung der Reichen und die Legalisierung von Marihuana. So ist anzunehmen, dass jene, die dem Modell "ihre Vorstellung davon, wie das Volk sprechen sollte", vermitteln, sich selbst politisch links verorten.

Diese moralische Ausrichtung der Sprachmodelle mag im Interesse der progressiven Kräfte liegen. Trotzdem stellt sich die Frage, was das für eine auf Kommunikation und Deliberation basierende Gesellschaft bedeutet, wenn ein paar Mitarbeiter eines privatwirtschaftlichen Unternehmens ohne politisches Mandat und gesellschaftliche Debatte ein Kommunikationsmittel manipulieren können, das immer wichtiger für die gesellschaftliche Meinungsbildung wird. Zu fragen ist auch: Was, wenn sich der Wind einmal dreht?

Die Tech Bros bei Trump

Genau das tut er gerade. Das zeigten die Bilder der CEOs der großen Tech-Unternehmen bei Donald Trumps Inaugurationsfeier am 20. Januar und beim Dinner im Weißen Haus am 5. September 2025. Diese Bilder lassen ebenso wie die unterwürfigen Schmeicheleien der CEOs für den US-Präsidenten keinen Zweifel: Den Chefs der Sprachmodelle ist der wirtschaftliche Erfolg wichtiger als die politische Gesinnung oder ein gutes Gewissen.

Sowohl Mark Zuckerberg, Vorstandsvorsitzender von Meta, als auch Sam Altman, der Gründer von Open AI, verkündeten 2025, dass ihre Sprachmodelle weniger linkslastig und weniger "politisch voreingenommen" sein sollen. Was bedeutet diese Wende für Europa und Deutschland, wo die amerikanischen Sprachmodelle ebenfalls dominieren?

Die Personalisierung der Perspektiven

Sind Sprachmodelle als kritische Infrastruktur zu betrachten, deren Kontrolle nicht in den Händen der privaten Wirtschaft, sondern der öffentlichen Hand liegen sollte? Sollten Sprachmodelle zur Informations- und Perspektivenvielfalt verpflichtet sein, so wie der Medienstaatsvertrag den öffentlich-rechtlichen Rundfunk dazu verpflichtet, "eine möglichst breite Themen- und Meinungsvielfalt ausgewogen" darzustellen?

Immerhin sind ChatGPT oder andere Sprachmodelle für viele eine beliebte Informationsquelle, wenn es um umstrittene Themen geht wie Gendern, Migration, Sexualunterricht oder Schwangerschaftsabbruch. Aber auch zum Verhältnis von Meinungsfreiheit und Blasphemie, individueller Freiheit und Gemeinschaft oder zur Frage, was der Zweck von Bildung ist und worin Glück besteht, gibt es unterschiedliche Ansichten. Nicht nur unter den verschiedenen Völkern, die ChatGPT benutzen, sondern auch innerhalb einer Nation.

Demokratischer Empfehlungsalgorithmus

Wie vermittelt ein Sprachmodell diese unterschiedlichen Perspektiven in die Gesellschaft? Und wie weit kommen die Vertreter verschiedener Strömungen dabei selbst zu Wort? Technisch machbar ist das durchaus, da quasi jede Perspektive im Datensatz des Sprachmodells enthalten ist. Dieses müsste nur so instruiert sein, dass es diese Wissensbestände auch abruft. Und zwar nicht nur für diejenigen, die eine bestimmte Perspektive haben, wie das Konzept des personalisierten Sprachmodells es vorsieht. Das wäre so, als würde die "Tagesschau" jeweils andere Meldungen für die Wähler der CDU, der SPD, der Linken oder der AfD senden - was im Zeitalter des Digitalfernsehens und des Datentrackings durchaus möglich wäre.

Eine solche Personalisierung würde freilich dem Auftrag einer umfassenden informationellen Grundversorgung der Bevölkerung widersprechen. Was bei den Privaten, die Profite erwirtschaften müssen, konsequent erscheint, verbietet sich den Öffentlich-Rechtlichen. Nicht anders sollte es bei Sprachmodellen und den darauf aufbauenden KI-Agenten sein. Geboten wäre ein demokratischer Empfehlungsalgorithmus, der weniger den Vorlieben des Individuums verpflichtet ist als den Bedürfnissen der Gesellschaft, also einer umfassenden Information ihrer Mitglieder. Ist ein solcher Algorithmus realistisch?

Zu jeder Frage eine fragile Antwort

Technisch wäre es kein Problem, ein Sprachmodell so einzustellen, dass es nicht erst auf konkrete Nachfrage hin weitere Perspektiven anbietet. Es könnte beispielsweise nach der Auskunft, was der Zweck von Bildung ist, selbst vorschlagen, diese Frage nun auch aus der islamischen Perspektive zu betrachten. Dann besteht Bildung nicht mehr in der Erziehung zum mündigen, selbstbestimmten Bürger - wie etwa im Westen in der Tradition des humanistischen Humboldtschen Bildungskonzepts. Vielmehr zielt Bildung dann auf die Erkenntnis der göttlichen Ordnung ("Taqwa"), auf die Pflichterfüllung gegenüber der Gemeinschaft ("Umma") und auf die Verteidigung der Wahrheit gegen den säkularen und "dekadenten" Westen.

So würde das Sprachmodell tatsächlich zum Sprachrohr verschiedener Völker, die in ihrer jeweils eigenen Perspektive sichtbar blieben, statt im Brei der Statistik unterzugehen. Aktuell ist es jedoch so, dass das Sprachmodell nach der Beantwortung der Frage vorschlägt, seine Antwort als Essay zu formulieren oder grafisch zu illustrieren, also die Antwort formal zu variieren, statt sie inhaltlich zu destabilisieren.

Vielfalt per Design?

Wäre diese Destabilisierung wünschenswert? Sie entspräche dem früheren Umgang mit Wissen, das darauf basierte, dass man nach dem Buch des einen Autors und Kulturkreis auch noch das eines anderen zur Kenntnis nahm. Warum sollte das Medium, das diese Kulturform des Wissens ersetzt, nicht gleichermaßen vorgehen? Zumal es ja auch global operiert.

Könnte man eine solche Vielfalt per Design gesetzlich durchsetzen? Hat der deutsche Staat (oder die Europäische Union) so viel Macht? Würde eine deutsche Regierung es wagen, sich gegen amerikanische KI-Unternehmen zu stellen? Oder wäre das übergriffig, weil ein global operierendes Sprachmodell eben doch etwas anderes ist als der national operierende Rundfunk? Und wie würde sich ein entsprechendes Aufsichtsgremium beziehungsweise ein erweitertes, demokratisiertes "Model-Behavior-Team" zusammensetzen? Wer entscheidet, welche Stimmen wie oft zu hören sind, wenn wir die KI zu den umstrittenen Themen des Lebens befragen?

Ein Gremium, in dem auch Nutzer vertreten sind

Wäre ein Oversight Board die Lösung, dasMartin Andree und Karl-Nikolaus Pfeifer kürzlich in einem Diskussionspapier mit dem Titel "Maßnahmen zur Wiederherstellung von Wettbewerb und Vielfalt im Markt der digitalen Medien" für Plattformen mit beherrschenden Stellungen vorschlagen? Ein Board, das nicht nicht nur aus Vertretern aus dem Management der Plattformen und der Vermarkter sowie aus Digital-Experten aus der Wirtschaft und der Regulierung bestehen sollte, sondern auch aus gewählten Vertretern der Content Kreatoren und der Plattform-Nutzer.

Wir sind fern von einer Antwort auf diese Fragen. So viel aber ist klar: Das Problem ist nicht technischer, sondern politischer Natur. Und als solches müsste es zunächst einmal erkannt und diskutiert werden. In diesem Kontext wäre die Frage zu stellen, wer wie und warum in den Sprachmodellen am Sprechen gehindert wird. Wenn der Gesetzgeber die Meinungsvielfalt garantieren will, muss er auch Sprachmodelle regulieren, die zwar meist privat genutzt werden, aber wegen ihres Einflusses auf die Meinungsbildung alles andere sind als eine Privatangelegenheit.

infobox: Dieser Text basiert auf dem Beitrag "Vielfalt per Dekret" von Roberto Simanowski, der im Portal und der Zeitschrift "Mediendiskurs" erschienen ist und auf seinem kürzlich erschienenen Buch "Sprachmaschinen. Eine Philosophie der künstlichen Intelligenz" (C.H.Beck 2025).

Copyright: Foto: Privat

Darstellung: Autorenbox

Text: Roberto Simanowski ist Kultur- und Medienphilosoph. Für sein Buch "Todesalgorithmus. Das Dilemma der künstlichen Intelligenz" (Passagen 2020) erhielt er 2020 den Tractatus-Preis.

Copyright: Foto: Privat

Darstellung: Autorenbox

Text: Roberto Simanowski ist Kultur- und Medienphilosoph. Für sein Buch "Todesalgorithmus. Das Dilemma der künstlichen Intelligenz" (Passagen 2020) erhielt er 2020 den Tractatus-Preis.

Zuerst veröffentlicht 14.02.2026 09:06

Schlagworte: Medien, Internet, Künstliche Intelligenz, Medienpolitik, Medienstaatsvertrag, Staatsvertrag, Simanowski

zur Startseite von epd medien